기본적인 딥러닝의 단계를 크게 4가지로 나누어 알아보고

딥러닝 단계

1. 데이터 가공 (통계)

2. 모델 설계 (선형대수)

3. 모델 트레이닝 (미분&적분)

4. 모델 테스트

딥러닝의 기초를 하기 위해 알아야할

선형대수

통계

미적분

중 미적분을 알아보자

첨부된 파일을 확인하면 날개념들을 볼 수 있다.

📌 1. 데이터 가공

딥러닝에서 모델을 학습시키기 위해서는 데이터를 수집하고 모델에 입력할 수 있도록 가공하는 과정을 거쳐야 한다.

이에 있어서 학습에 필요한 데이터, 필요 없는 데이터를 구별해, 트레이닝과 테스트에 유리하도록 변환해 주어야 한다

여기서 통계의 정규화 지식이 필요하다.

정규화란?

관계형 데이터베이스의 설계에서 중복을 최소화하기 데이터를 구조화하는 프로세스를 정규화라고 함. 함수의 종속성을 이용해 연관성 있는 속성들을 분류하고, 각 릴레이션들에서 이상현상이 생기지 않도록 하는 과정을 말함.

딥러닝에서 모든 데이터 포인트가 동일한 정도의 스케일(중요도)로 반영되도록 해주는게 정규화의 목표이다.

간단히 말해서 데이터 단위의 불일치로 인해 일어날 수 있는 문제점을 해결하는 방법중 하나이다. 표준화의 방법도 있다.- 정규화

데이터를 특정 구간으로 바꾸는 척도법임

(측정값 - 최소값) / (최대값 - 최소값)

데이터 군 내에서 특정 데이터가 가지는 위치를 볼 때 사용됨

현재 데이터가 어느 위치에있는지 파악하기 좋다- 표준화

데이터를 0을 중심으로 양쪽으로 분포시키는 방법임.

평균을 기준으로 얼마나 떨어져 있는지를 나타내는 값으로 변환됨.

학교 <확률과 통계> 시간에 배우는 표준화( 측정값 - 평균 / 표준편차 )도 단위차이의 문제에서 벗어날 수있게 해주는 종류중 하나이다.

가장 일반적인 정규화 방식은 MIN-MAX 정규화이다.

(다른 방법으로는 Z-Score 정규화 방법도 있다.)

두 정규화의 방식은 다음 포스팅에서 알아보자 (?

📌 2. 모델 설계

데이터를 알맞게 모았다면 딥러닝이 읽을 수 있도록 데이터의 형식을 맞춰줘야 한다.

여기서 데이터 형식과 데이터 연산 방식에 있어서 선형대수 지식이 필요하다 .

📌 데이터 형식

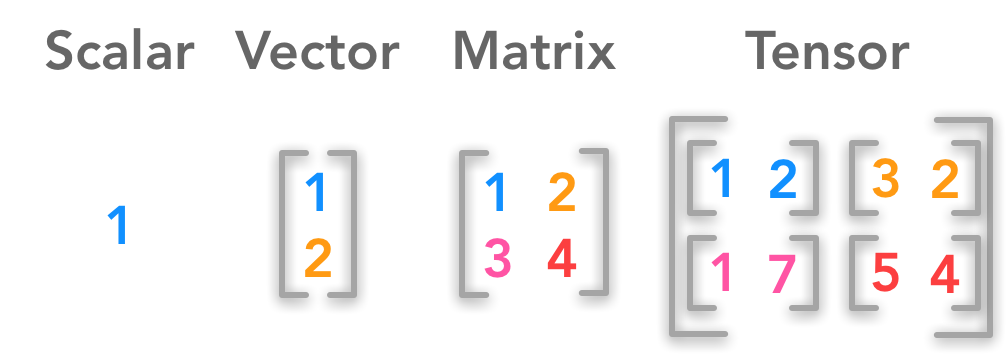

선형대수에서 크게 스칼라(0차), 벡터(1차), 행렬(2차), 텐서(N)의 4가지의 형식을 가진다.

딥러닝에서 다루는 데이터는 텐서(N차)인데

텐서가 0차원 : 스칼라

텐서가 1차원 : 벡터

텐서가 2차원 : 행렬

이라고 볼 수 있다.

딥러닝에서 이러한 텐서를 이용하여 연산 수행을 통해 모델을 학습시키게 된다.

📌데이터 연산

위에서 언급했던바와 같이 딥러닝에서 다루는 데이터는 **텐서**이다.

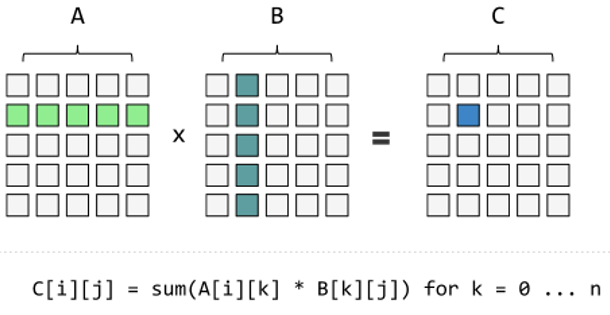

이를 연산하기 위해 **행렬의 연산**이 쓰인다

행렬의 연산과정은 고등학교에서 배우는 과정이지만 2015교육과정을 기점으로 사라졌다. 사실

나도 배운적 없다

행렬의 연산 중 곱셈은 다음과 같다.

그 외의 연산방법들은 위에 첨부된 pdf를 참고하자

📌 3. 모델 트레이닝

딥러닝에서 모델 트레이닝은 Trial-Error방식으로 이루어지는데

말 그대로 일단해봄 ☞ 오차 계산 ☞ 오차만큼 파라미터 값 보정하는 방식이라 볼 수 있다.

여기서 파라미터 값을 보정하는데 미분&적분의 개념이 이용된다.

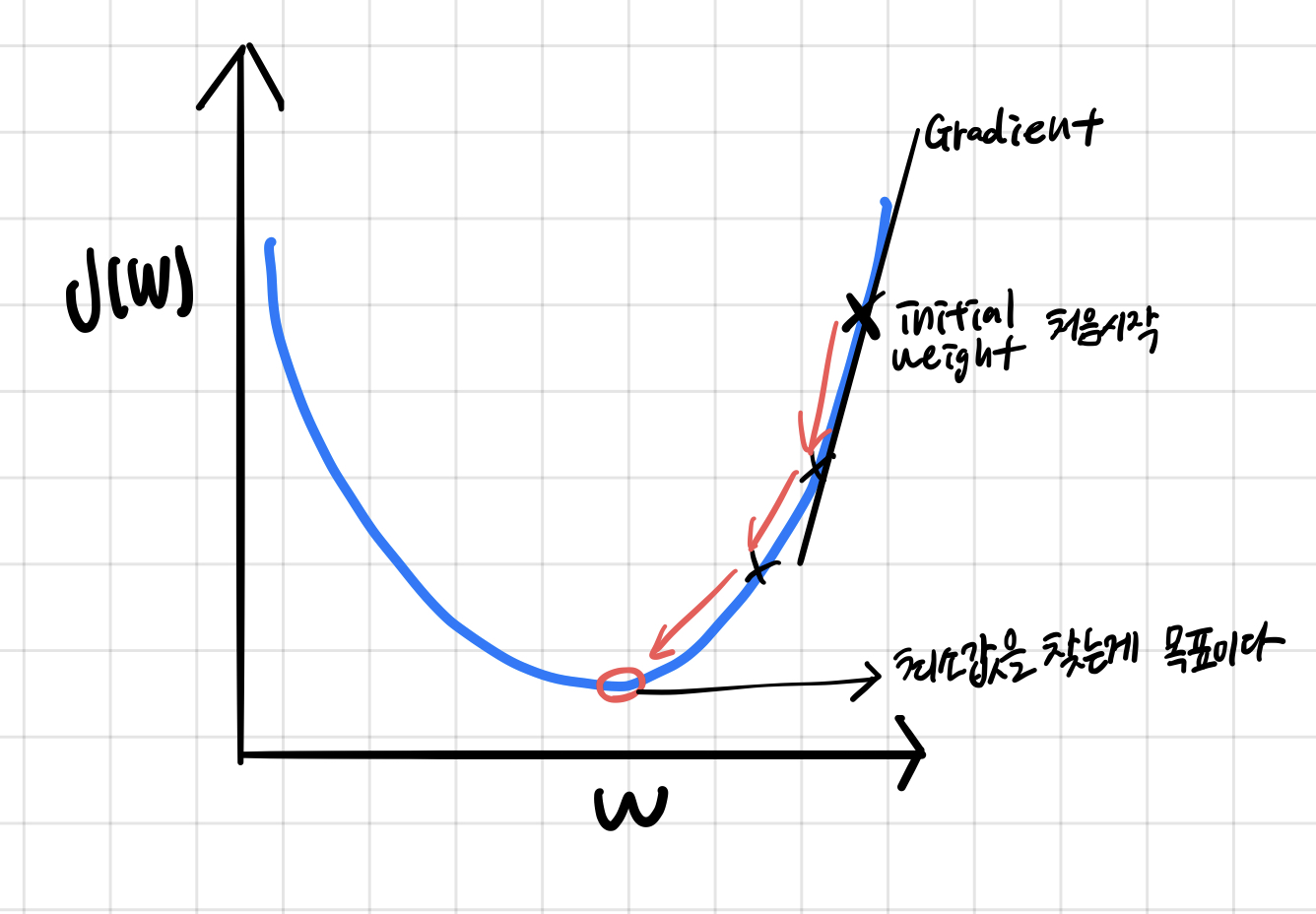

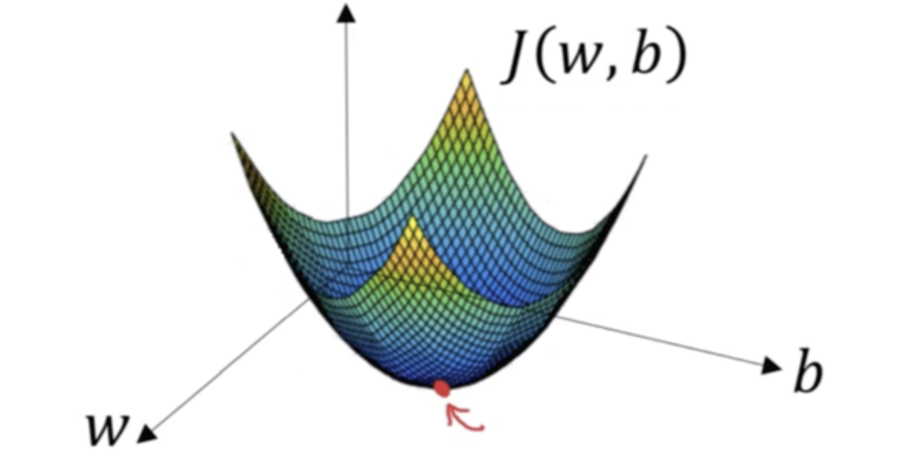

가장 일반적으로 사용되는 보정은 **Gradient Descent 방법**이다.

오차가 최소가 되는 W값을 찾기 위해 미분을 통해 구현한 Gradient값에 따라 W값을 변화시키는 방법이다.

1차 근삿값 발견용 최적화 알고리즘이다.

함수의 기울기를 구한 후 기울기가 낮은쪽으로 계속 이동시켜 극값에 이를 때까지 반복시키는 것이다.

📌

경사법, 수치 미분

파이썬 구현

간단히 아주 작은 간격의 구간의 기울기를 구하는것이다.

학교에서 배우는 정적분과 부정적분 개념이다.

이러한 미분하는 과정을 파이썬으로 구현해 보자 (파이선 def함수 맞습니다. 티스토리 코드블럭이 익숙치 않아서 들여쓰기가 안맞을뿐)

def numerical_diff(f,x):

h = 1e-4 #h값을 가급적 작은 값을 대입하고자 e를 이용했다 -> 0.0001

return (f(x+h)-f(x-h))/2*h

# 오차를 줄이기 위한 중심차분을 이용함

# 고등학교에서 x+h-(x-h) =2h로 계산하던 그 과정 맞다

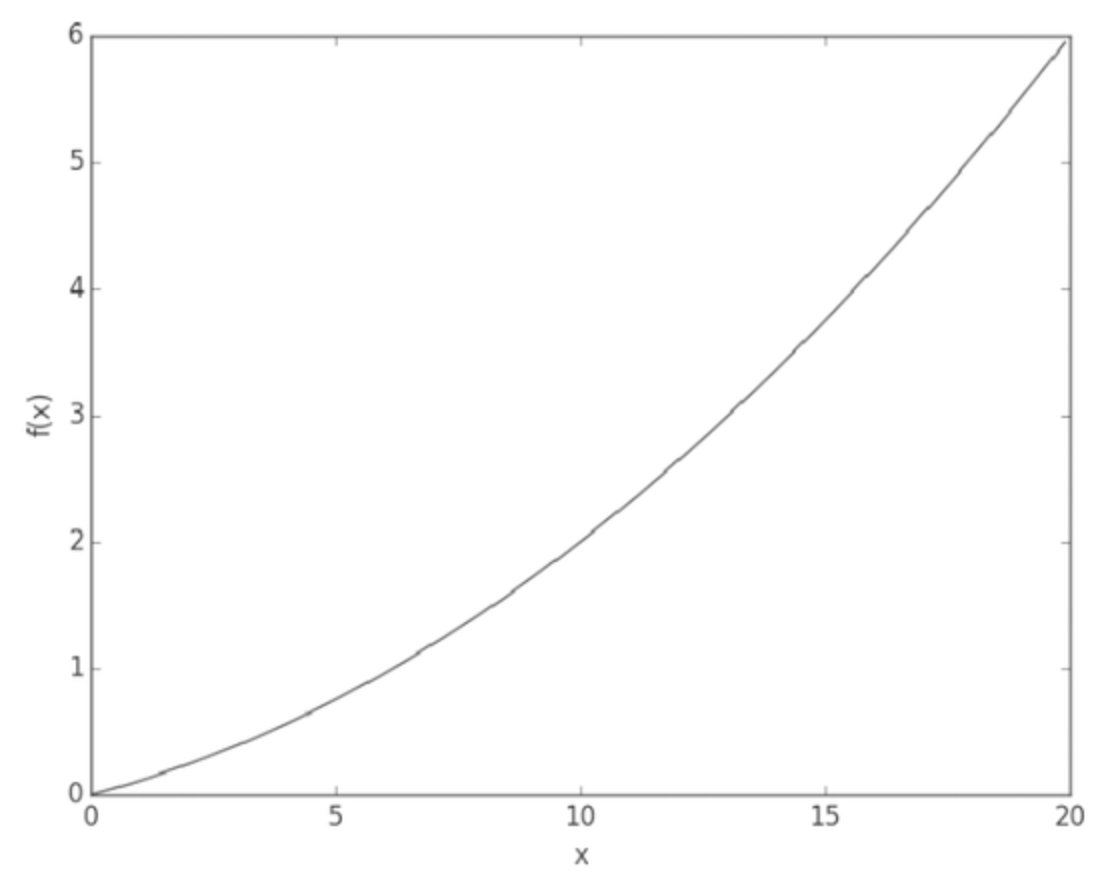

간단히 2차함수 (y = 0.01x^2 + 0.1x) 를 그리고 미분한 값을 확인해 보자

#coding:utf-8

import numpy as np

import matplotlib.pyplot as plt

def numerical_diff(f,x):

h = 1e-4

return(f(x+h)-f(x-h))/2*h

def function(x):

return 0.01*x**2 + 0.1 * x

#그래프로

x = np.arange(0.0,20.0,0.1)

y = function(x)

plt.xlable("x")

plt.ylable("f(x)")

plt.plot(x,y)

plt.show()

print(numerical\_diff(function,5))를 찍어보면 x가 5일때의 미분값을 구할 수 있다.

1.9999999999908982e-09로 나오는데 미분했을 때 값이 0.2인걸 보면 거의 오차가 없을 정도이다

미분이 되는걸 확인 했으니 실제 딥러닝에서 쓰이는 편미분(변수가 여럿)을 해보자

여기부터는 https://m.blog.naver.com/ssdyka/221299637545을 참고했습니다

def function_2(x):

return x[0]**2 + x[1]**2

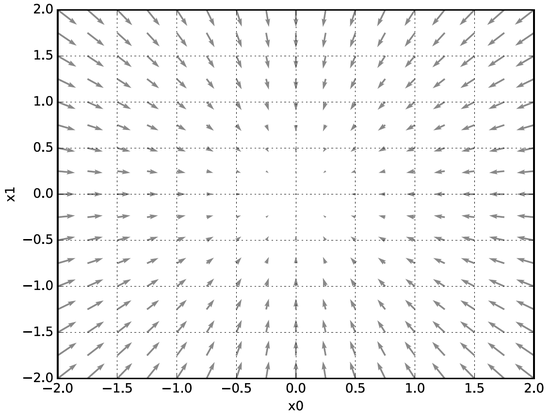

편미분을 동시에 계산 (각 변수별로 따로 계산하는게 아니라 동시에)하고자 하면

모든 변수의 편미분의 벡터로 정리해 계산하고 이것을 기울기(gradient)라 한다.

(x0,x1)의 각 점에서 기울기를 동시에 얻을 수 있다

# coding: utf-8

import numpy as np

def numerucal_gradient(f,x):

h = 1e-4 #0.0001

# x와 형상이 같은 배열에 모두0인 값

grad = np.zeros_like(x)

for idx in range(x.size):

tmp_val = x[idx]

# f(x+h) 계산

x[idx] = tmp_val+h

fxh1 = f(x)

# f(x-h) 계산

x[idx] = tmp_val-h

fxh2 = f(x)

grad[idx] = (fxh1-fxh2)/(2*h)

x[idx] = tmp_val

return grad

def function_2(x):

# return x[0]**2 + x[1]**2

return np.sum(x**2)

print(numerucal_gradient(function_2, np.array([3.0,4.0])))

print(numerucal_gradient(function_2, np.array([0.0,2.0])))

print(numerucal_gradient(function_2, np.array([3.0,0.0])))

# [6. 8.]

# [0. 4.]

# [6. 0.]기울기를 그림으로 그려 화살표로 알아볼 수 있다 (벡터값)

# coding: utf-8

# cf.http://d.hatena.ne.jp/white_wheels/20100327/p3

import numpy as np

import matplotlib.pylab as plt

from mpl_toolkits.mplot3d import Axes3D

def _numerical_gradient_no_batch(f, x):

h = 1e-4 # 0.0001

grad = np.zeros_like(x) # x와 형상이 같은 배열을 생성

for idx in range(x.size):

tmp_val = x[idx]

# f(x+h) 계산

x[idx] = float(tmp_val) + h

fxh1 = f(x)

# f(x-h) 계산

x[idx] = tmp_val - h

fxh2 = f(x)

grad[idx] = (fxh1 - fxh2) / (2*h)

x[idx] = tmp_val # 값 복원

return grad

def numerical_gradient(f, X):

if X.ndim == 1:

return _numerical_gradient_no_batch(f, X)

else:

grad = np.zeros_like(X)

for idx, x in enumerate(X):

grad[idx] = _numerical_gradient_no_batch(f, x)

return grad

def function_2(x):

if x.ndim == 1:

return np.sum(x**2)

else:

return np.sum(x**2, axis=1)

def tangent_line(f, x):

d = numerical_gradient(f, x)

print(d)

y = f(x) - d*x

return lambda t: d*t + y

if __name__ == '__main__':

x0 = np.arange(-2, 2.5, 0.25)

x1 = np.arange(-2, 2.5, 0.25)

X, Y = np.meshgrid(x0, x1)

X = X.flatten()

Y = Y.flatten()

grad = numerical_gradient(function_2, np.array([X, Y]) )

plt.figure()

plt.quiver(X, Y, -grad[0], -grad[1], angles="xy",color="#666666")#,headwidth=10,scale=40,color="#444444")

plt.xlim([-2, 2])

plt.ylim([-2, 2])

plt.xlabel('x0')

plt.ylabel('x1')

plt.grid()

plt.legend()

plt.draw()

plt.show()가장 낮은 장소를 가리키게 되어있으며

가장 낮은곳과의 거리가 멀어짐에 따라 화살표의 크기도 따라 커진다.

가장 낮은곳을 가리키고 있는 화살표의 방향처럼 딥러닝의 모델 트레이닝 과정은 j(w)의 가장 낮은 값을 찾아가는 과정이다.

'Develop Study 💻' 카테고리의 다른 글

| MYM Edu illust (0) | 2021.01.16 |

|---|---|

| mongoDB 컬렉션 생성 (0) | 2021.01.15 |

| python으로 균일분포, 정규분포, 감마분포, 이항분포 구현하기 (0) | 2020.08.25 |

| 멜론 차트 가져오기 멜론차트 크롤링 java (0) | 2020.08.06 |

| github (0) | 2020.08.04 |